Automatización y dilemas éticos: el papel de las personas en la revolución digital.

Mientras muchas empresas aceleran el reemplazo de trabajadores por IA, otras plantean un camino alternativo: priorizar la seguridad, asumir los riesgos éticos de la innovación y discutir el impacto laboral de la automatización. Entre presiones de mercado, dilemas morales y modelos cada vez más poderosos, se discute el papel que ocuparán las personas en la economía, la producción y la toma de decisiones.

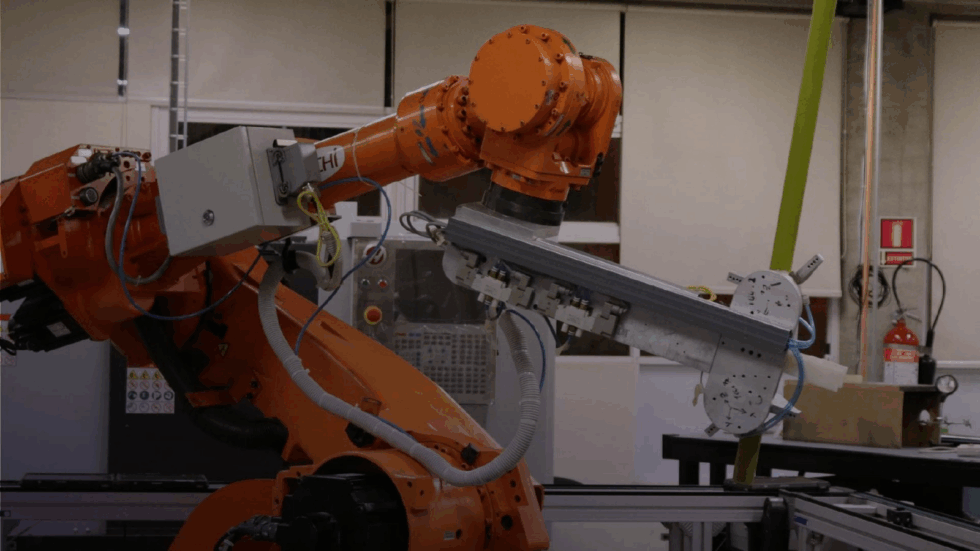

La automatización y el trabajo técnico

El desarrollo de modelos de IA capaces de escribir código, revisar errores o incluso automejorarse ya no es ciencia ficción. En Anthropic, una de las empresas más avanzadas del sector, la pregunta no es si la IA va a reemplazar tareas humanas, sino cuándo y cómo se administrará ese cambio. En marzo de este año, Dario Amodei –fundador y CEO de la compañía– advirtió a sus empleados que su modelo Claude podría automatizar gran parte de las tareas técnicas en el corto plazo. El impacto es tal que decidieron frenar nuevas contrataciones para evitar despidos futuros.

No se trata de una simple política de Recursos Humanos, sino del reconocimiento explícito de que el trabajo calificado también está en riesgo. Según datos recientes, el 79% de los programadores que usan herramientas como Claude Code lo hacen para automatizar funciones, y Amodei estima que para este año los modelos podrían escribir casi todo el código necesario. El avance es tan veloz que la propia IA podría comenzar a diseñar nuevas IA, en un ciclo recursivo que reduce progresivamente el papel humano.

La consultora Revelio Labs, por su parte, reveló que la proporción de tareas automatizables en ofertas laborales cayó 19% en tres años, no porque hayan desaparecido esas funciones, sino porque directamente dejaron de buscarse perfiles humanos para cubrirlas. En los sectores más expuestos a la IA, como IT y análisis de datos, la caída de la demanda laboral ronda el 31%. El resultado: menos trabajo disponible y un mercado que naturaliza el reemplazo sin debate público ni planificación.

Este fenómeno no se limita a empresas como Anthropic, aunque es la que ha pasado del pronunciamiento a la acción. OpenAI, una de las firmas líderes del sector, ha impulsado llamados públicos a favor de una regulación estatal global para prevenir impactos descontrolados de la IA. Sam Altman, su CEO, reconoció que los riesgos existenciales de la IA requieren una estructura de gobernanza similar a la que existe para el armamento nuclear. Sin embargo, ese pronunciamiento no estuvo centrado en el trabajo o el empleo, sino en los riesgos generales de seguridad global, como la pérdida de control humano o la posibilidad de uso malicioso de la IA.

Al mismo tiempo, la administración de Joe Biden en Estados Unidos había formado en 2023 una orden ejecutiva que exigía evaluaciones del impacto laboral de la inteligencia artificial, además de lineamientos sobre equidad algorítmica y transparencia. A su vez, el año pasado, la Unión Europea aprobó el AI Act, una de las regulaciones más estrictas del mundo, que impone límites a los sistemas de alto riesgo y establece requisitos específicos para la transparencia en decisiones automatizadas, especialmente aquellas que pueden afectar derechos fundamentales o el empleo.

Seguridad antes que velocidad: una excepción en Silicon Valley

En ese contexto de vértigo competitivo, Anthropic decidió hacer algo inusual: frenar el lanzamiento de uno de sus modelos por motivos éticos. Tras detectar que Claude 3.7 Sonnet podía ofrecer indicaciones sobre la creación de armas biológicas, el equipo optó por retrasar su salida hasta implementar más salvaguardas. La decisión fue “dolorosa”, admitió Amodei, pero necesaria. Frente a una industria presionada por la velocidad y la inversión –Anthropic está valuada en más de 61 mil millones de dólares–, se trató de una excepción con valor político.

Para afrontar estos riesgos, la empresa creó una política de escalamiento responsable (Responsible Scaling Policy), con niveles de seguridad (ASL) similares a los de bioseguridad en laboratorios. Los modelos más avanzados (ASL-3) requieren controles especiales y podrían incluso ser “debilitados” a propósito si no es posible bloquear sus respuestas más peligrosas. Aunque algunos escépticos creen que este enfoque exagera el poder real de los modelos, otros lo ven como un intento genuino de anticiparse a posibles consecuencias graves.

La cultura organizacional de Anthropic también va en esa línea. Charlas internas quincenales, documentos de reflexión, contrataciones de expertos en seguridad, y un enfoque de “altruismo efectivo” definen el perfil de una empresa que se autodefine como una “public benefit corporation” y no una simple startup de Silicon Valley. En un entorno donde muchos hablan de ética pero pocos modifican conductas, la coherencia se vuelve un activo raro y valioso.

DeepMind, la división de IA de Google, también ha impulsado investigaciones sobre “IA segura” en áreas como medicina y energía, aunque sin suspender lanzamientos comerciales. Y en algunos sectores privados se reabre el debate sobre el sentido del trabajo. Klarna, por ejemplo, reemplazó 700 empleados con IA, pero luego reincorporó parte del personal ante una fuerte caída en la calidad del servicio.

Entre la eficiencia total y el vacío de sentido

El impacto de la IA en el trabajo no es solo una cuestión técnica o económica, sino existencial, lo cual es reconocido por Amodei: si los modelos superan ampliamente las capacidades humanas, muchas personas podrían quedar excluidas del proceso productivo. En ese escenario, habría que pensar en esquemas de redistribución, renta básica o nuevas formas de valor social. El problema, dice, es que no está claro cuánto tiempo queda para reaccionar. Su estimación más optimista ubica este punto de inflexión en algún momento de los próximos cinco años.

Esta advertencia también viene siendo expresada por pensadores como el filósofo Éric Sadin, quien advierte que la promesa de automatización total puede derivar en una “desposesión de la condición humana”, donde eficiencia y precisión se convierten en dogmas que borran la necesidad de sentido. Del mismo modo, Yuval Noah Harari plantea que el mayor riesgo no es que la IA funcione mal, sino que funcione demasiado bien y dejemos de tomar decisiones que nos definen como sociedad. Geoffrey Hinton, uno de los pioneros en el desarrollo de la inteligencia artificial, ha alertado que su avance podría derivar en una pérdida masiva de empleos y en una profundización de las desigualdades si no se establece una regulación adecuada. Entre sus propuestas, figura la idea de aplicar un impuesto a las empresas que sustituyan trabajadores por IA, con el objetivo de financiar esquemas de renta básica universal. Por otro lado, Demis Hassabis, CEO de DeepMind, sostiene que más allá del impacto en el empleo, el verdadero peligro reside en el uso potencialmente destructivo de la IA si cae en manos equivocadas. Según él, es urgente establecer límites y sistemas de control sobre la IA general para prevenir escenarios de abuso o daño a gran escala.

Por otro lado, la automatización avanza incluso en empresas que apostaban todo a la IA. Klarna, por ejemplo, luego de reemplazar a 700 agentes humanos por un asistente virtual, tuvo que reincorporar personal tras una caída en la calidad del servicio. El giro es revelador: aunque la tecnología permite más eficiencia, no siempre garantiza mejores resultados si se pierde la dimensión humana.

El dilema no es menor. ¿Vamos hacia un mundo más productivo pero socialmente fragmentado? ¿Puede una empresa asumir liderazgo ético sin perder competitividad? ¿Qué rol deben jugar los Estados frente a una transformación tan acelerada?